■生成AIの基本からご覧になりたい方はこちら

【2025年最新】生成AIとは?仕組みやメリットをやさしく解説

■情報セキュリティを基礎から実践まで学たい方はこちら

2025年版】情報セキュリティ10大脅威と企業が取るべき対策を分かりやすく解説

シャドーITは問題だが、シャドーAIも問題

ビジネスパーソンであれば、「シャドーIT」という言葉を聞いたことがある人は多いことでしょう。これは従業員が業務において、社内で使用が許可されていないクラウドサービスやアプリケーションを勝手に使用することを指す言葉です。

たとえば他社のビジネスパートナーに大容量のファイルを共有する際、会社は従業員に対し、セキュリティレベルの高いAというサービスの使用を命じているものの、実際にはAよりも使い勝手の良いBというサービスが使用されてしまっている、といったようなケースがシャドーITに該当します。

現場の従業員としては、より便利なサービスを使いたがるのは仕方がないかもしれません。とはいえ会社としては、たとえ使いやすいとしても、セキュリティ面で不安の残るサービスを使うことで、トラブルを招くのは避けたいところです。不測の事態を避けるためにも、業務で使用するツールを限定し、シャドーITを防ぐための努力は、ビジネスには欠かせない取り組みのひとつです。

しかし最近では、シャドーITに加え「シャドーAI」についても、企業は対策を練らなければいけない時代になりつつあります。

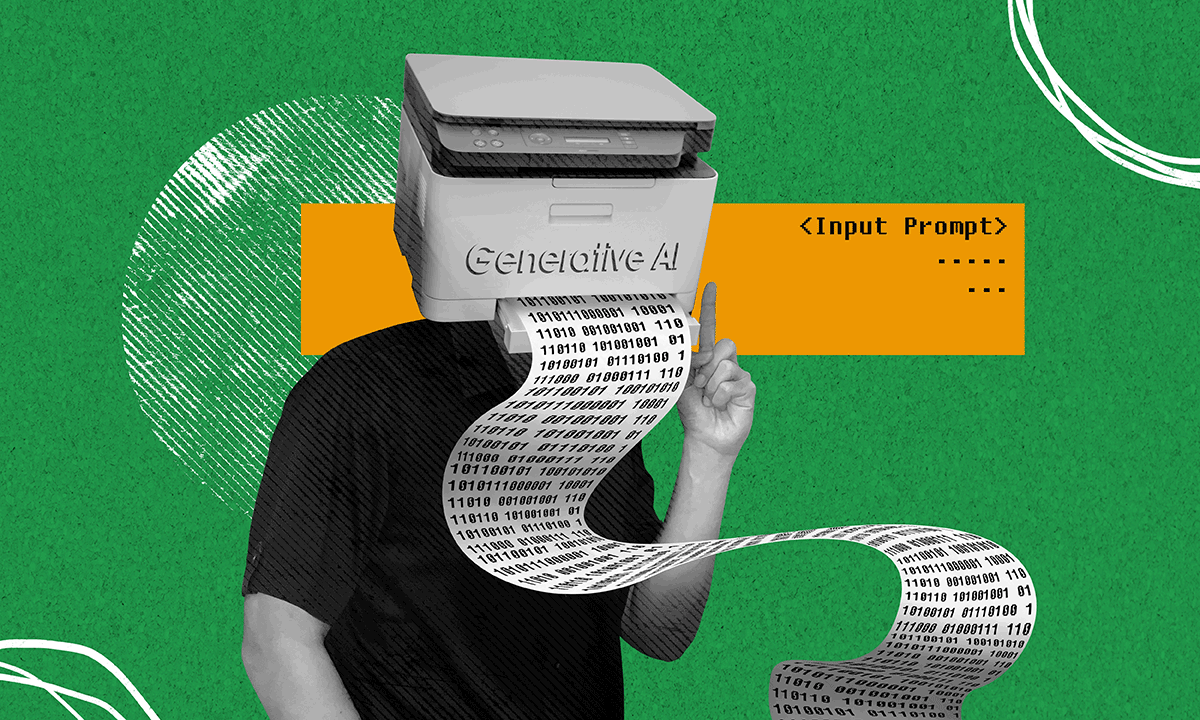

生成AIに入力した命令文が、

学習データとして記憶されている?

シャドーAIとは、企業のIT部門が承認・管理していない生成AIなどのAIツールを、従業員が個人の判断で業務に利用することを指す言葉です。簡単にいえば、シャドーITの生成AIバージョンです。

OpenAIのChatGPTや、GoogleのGeminiに代表される生成AIは、簡単なプロンプト(命令文)を入力するだけで、自動的に文章や画像などをアウトプットする便利なツールです。総務省が2025年7月に発表した令和7年版 情報通信白書によると、“何らかの業務で生成AIを利用している”と回答した日本企業の割合は55.2%と、過半数を超えています。

とはいえ、ビジネスシーンで生成AIを使用することは、リスクを伴う恐れがあります。代表的なリスクのひとつが「情報漏えい」です。

生成AIの中には、プロンプトに入力された情報を学習データとして記憶するものが存在します。そのため、個人情報や機密情報をプロンプトに入力した場合、そのデータを生成AIが学習し、別のユーザーの回答として出力される恐れが存在します。たとえ回答として出力されなくても、生成AIの学習データが何者かによって不正アクセスされたり、AIが予期せぬ動作をすることで、情報が第三者の手に渡る恐れがあります。

一度生成AIに学習された情報は、簡単に消去することは困難です。実際に、ある生成AIサービスにおいて、第三者が入力したプロンプトの内容が閲覧可能な状態にあったという事件も発生しています。

こうした生成AIの利用による情報漏えいは、企業のIT部門が正しく対策をすることで、防止することが可能です。しかし、従業員が勝手にシャドーAIを利用している場合、対策が不十分で、プロンプトに入力した情報が学習されてしまうリスクを伴います。

入力内容が学習されないよう、

対策済みのサービスもある

企業がビジネスにおいて生成AIを使用するリスクとその対策については、公的な機関が指針を発表しています。たとえばIPA(独立行政法人 情報処理推進機構)では、2024年7月に「テキスト生成AIの導入・運用ガイドライン」という資料をリリースしています。

同ガイドラインでは、生成AIを利用する際、プロンプトに氏名や住所、電話番号といった個人情報、組織の内部文書や秘密保持契約を締結した情報が含まれていると、情報が学習し生成され、プライバシーの侵害や組織の機密情報が漏えいするリスクがあるとしています。

特に、顧客情報や機密情報、外部公開前の情報を取り扱う業務や、業務以外の目的での使用の場合は、業務における生成AIの利用制限を検討すべきとしています。

多くの生成AIのサービスでは、プロンプトに入力データをAI学習に使用しないよう、設定を変更することが可能です。たとえばChatGPTでは、設定にて「全ての人のためにモデルを改善する」というスイッチをOFFにすることで、入力データが自動で学習されなくなります。

ビジネスシーン向けの生成AIサービスでは、そもそも学習機能がデフォルトでOFFに設定されているケースもあります。たとえばGoogleのビジネス用クラウドサービス「Google Workspace」では、同社の生成AI「Gemini」を学習しない設定で使用することが可能です。

IPAが挙げた先の資料では、企業が業務に生成AIを利用する際には、社内でガイドラインを作成・設定することが重要としています。ガイドラインが社内に無い場合、生成AIの利用方法をユーザーが自己判断せざるを得ず、重要な情報をプロンプトに入力してしまうだけでなく、効果的な利用方法がわからず、従業員が生成AIの利用を止めてしまう事態が発生する可能性が高いとし、各社でガイドラインの作成と準備を呼びかけています。

生成AIのビジネスリスクを減らす社内ルール整備術はこちら

「生成AIは危険だから全面禁止」は、

かえってシャドーAIを誘発する

ここまで挙げてきたように、ビジネスシーンにおける生成AIの使用は、無策であれば情報漏えいの恐れがあるものの、自社内でルールを設定し、正しい使用法を守ることで、リスクを抑えることが可能です。

中には「そもそも使わなければ、情報漏えいのリスクは無い!」として、生成AIの使用を全面的に禁止している企業もあるかもしれません。しかしこれでは、従業員が隠れて便利な生成AIを使う原因となり、かえってシャドーAIのリスクが拡大しかねません。

さまざまな場面でAIの活用が進む現代において、シャドーAIを防ぐためには、IT部門が社内でガイドラインを作成し、安全に生成AIを使うための環境を整えることが求められます。たとえばIT部門が社内ネットワークの通信ログを監視する仕組みを構築すれば、社内で許可されていない生成AIが使用されていないかどうかをチェックすることも可能です。

本記事で繰り返し触れた通り、生成AIはリスクを内包している点は事実です。しかし、事前に対策を打つことで、ビジネスシーンでも安全に使うことが可能です。まだ社内に生成AI使用のルールを定めていないのであれば、業務を効率化するためにも、シャドーAIのリスクを抑えるためにも、積極的に導入を進めるべきでしょう。

EN

EN